ช่วงนี้ OpenAI กำลังลองใช้ Google TPUs กันอยู่ ถึงแม้จะยังไม่พร้อมเอามาใช้จริงจังในเชิงพาณิชย์ แต่เอาเข้าจริงก็พอจะบอกได้ว่า OpenAI กำลังหาทางจัดการกับค่าใช้จ่ายที่เพิ่มขึ้นในงาน inference หรือกระบวนการประมวลผล AI ที่ใช้ทำนายหรือสร้างคำตอบเมื่อได้รับคำถาม

ทำไม OpenAI ถึงสนใจ TPUs ของ Google?

ตัวแทนของ OpenAI บอกกับ Reuters ว่า ตอนนี้กำลังทดสอบ TPUs ของ Google เบื้องต้นก่อน แต่ยังไม่มีแผนจะใช้กว้างๆ ทันที

เรื่องนี้ก็สอดคล้องกับความจริงที่ว่า โมเดลภาษาขนาดใหญ่ หรือ LLMs ที่ OpenAI ใช้อยู่ กำลังเรียกใช้ทรัพยากรประมวลผลแบบโหดมาก พอๆ กับที่ราคาการ์ด Nvidia GPU ก็พุ่งสูงจนแทบหาคนจับจองไม่ได้

นักวิเคราะห์อย่างชาร์ลี ได จาก Forrester บอกว่า ค่าใช้จ่ายสำหรับการทำ inference นี่แหละ เป็นตัวแปรสำคัญที่ทำให้หลายๆ เจ้าเริ่มมองหาชิป AI ที่แตกต่างจาก Nvidia GPU

- พวกเขาเริ่มหาชิปทางเลือกเพื่อประหยัดค่าใช้จ่ายและเพิ่มประสิทธิภาพในการทำงาน

- เพราะงานในส่วนนี้เป็นตัวกำหนดว่าใครจะได้กำไร หรือขาดทุนกันในตลาด AI

OpenAI กำลังทำอะไรในแง่ฮาร์ดแวร์?

จากที่ OpenAI ทดสอบ TPUs ก็น่าจะหมายความว่า พวกเขากำลังดูฮาร์ดแวร์เจ๋งๆ ที่ช่วยลดต้นทุนและเพิ่มประสิทธิภาพแจกแจงงาน AI ของตัวเองด้วย

Barclays ประเมินว่า ค่าลงทุนในชิปสำหรับงาน AI inference จะพุ่งไปเกิน 1.1 ล้านล้านดอลลาร์ในปี 2028 เลยทีเดียว และ OpenAI ก็อาจจะต้องหาทางประหยัดด้วยการใช้ชิปเฉพาะทาง เช่น ASIC ในอนาคต

เหตุผลที่ Google TPUs น่าสนใจต่อ OpenAI

- ค่าใช้จ่ายในการทำ inference ตอนนี้กินต้นทุนราว 50% ของงบค่าประมวลผลทั้งหมดของ OpenAI

- TPUs รุ่นเก่าที่ Google มีราคาต่อคำตอบถูกกว่าการ์ด Nvidia อย่างชัดเจน

- ถึงแม้ TPUs รุ่นเก่าจะแรงน้อยกว่า GPU รุ่นใหม่ๆ แต่ดีไซน์ที่เน้นประสิทธิภาพและประหยัดพลังงานทำให้คุ้มกว่าเมื่อนำไปใช้กับงานขนาดใหญ่

- หลายคนใช้งาน AI รายงานว่า TPUs ให้ประสิทธิภาพการคำนวณ FLOPS ที่ดีกว่าฮาร์ดแวร์อื่นๆ

- TPUs รุ่นต่างๆ ที่ Google Cloud เปิดขายมีตั้งแต่ v2 ไปจนถึง v6 (หรือที่เรียกว่า Trillium) โดยบางรุ่นยังมีเวอร์ชันสำหรับประหยัดพลังงานด้วย

- ล่าสุด Google เพิ่งเปิดตัว TPU ชุด Ironwood ที่มีประสิทธิภาพดีกว่าและราคาดีกว่าชิปเจ้าอื่นๆ ซึ่ง OpenAI อาจทดลองด้วยแต่ยังไม่น่าจะสั่งซื้อเยอะตอนนี้

เทรนด์กระจายแหล่งชิปและเลือกใช้ฮาร์ดแวร์เฉพาะทาง

ถ้า OpenAI ใช้ TPUs จริง ก็จะทำให้แหล่งชิปที่ OpenAI ใช้งานกระจายตัวมากขึ้น ช่วยลดปัญหาเรื่องขาดแคลน GPU และเพิ่มพลังต่อรองราคาด้วย

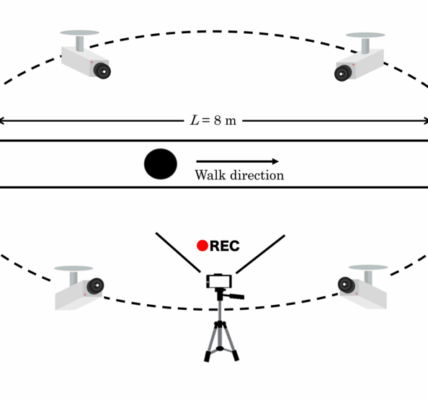

ณ ตอนนี้ OpenAI มีผู้จำหน่ายชิปหลักคือ Microsoft, Oracle และ CoreWeave และยังทดลองใช้ชิปเฉพาะทางสำหรับงาน AI อย่าง AWS Trainium หรือ Microsoft Maia ที่ออกแบบเพื่อเร่งความเร็ว inference โดยเฉพาะ

แต่มีความเป็นไปได้ว่า OpenAI กำลังเจรจาข้อตกลงพิเศษกับ Google เพื่อนำ TPUs มาใช้ทำงานด้านใน เช่น การทดสอบ หรือการฝึกอบรมพนักงาน มากกว่าจะใช้เพื่อบริการลูกค้าทันที

สรุปให้ฟังแบบเข้าใจง่ายๆ

- OpenAI กำลังทดลองใช้ Google TPUs เพราะค่าใช้จ่ายในงาน AI ที่เรียกว่า inference กำลังเพิ่มสูงขึ้นมาก

- TPUs ถึงจะไม่แรงเท่า GPU รุ่นใหม่ แต่ต้นทุนต่อหน่วยต่ำกว่าและประหยัดพลังงานกว่า ทำให้มีโอกาสลดค่าใช้จ่ายจริงจัง

- OpenAI ต้องกระจายแหล่งชิป เพื่อป้องกันปัญหาคอขวดและต่อรองราคากับผู้ผลิต

- นอกจาก GPU ยังมี ASIC และชิปเฉพาะทางอื่นๆ ที่ช่วยเร่งการประมวลผล AI โดยเฉพาะ

- นี่คือสัญญาณว่าภาคธุรกิจ AI กำลังพัฒนาไม่หยุด เพื่อให้คนรุ่นใหม่ที่ทำงานหรืออยากทำธุรกิจส่วนตัวมีเครื่องมือ AI ที่คุ้มค่าและประสิทธิภาพดี

ที่มาของข้อมูล https://www.networkworld.com/article/4015386/openai-tests-google-tpus-amid-rising-inference-cost-concerns.html